L’IA : un levier d’amélioration ou un risque pour le recrutement ?

Automatiser le recrutement : jusqu’où l’intelligence artificielle peut-elle aller ?

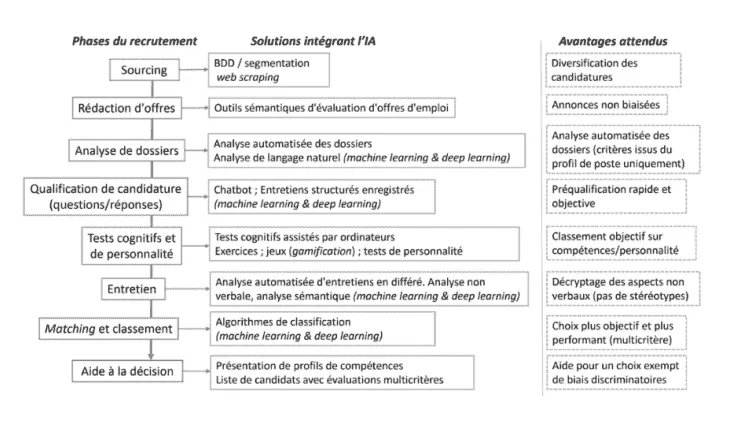

L’intelligence artificielle peut aujourd’hui se positionner à chaque étape du recrutement :

Un schéma récapitulatif issu de l’étude Good in Tech, réalisée en collaboration avec des chercheurs de l’IMT et de Sciences Po.

De nombreuses technologies basées sur l’intelligence artificielle (IA) transforment aujourd’hui le processus de recrutement, du sourcing à la conduite d’entretiens par des agents virtuels automatisés. Ces outils permettent d’optimiser les différentes étapes du recrutement en les rendant plus rapides, plus fluides et plus précises.

L’un des principaux avantages de l’IA réside dans sa capacité à automatiser les tâches répétitives et chronophages. Les ressources humaines peuvent ainsi se concentrer sur des missions à plus forte valeur ajoutée, comme l’évaluation des soft skills ou la définition des stratégies de développement des talents.

Sourcing

Le sourcing consiste à constituer un vivier de candidats potentiels à partir duquel les recruteurs pourront sélectionner les profils les plus pertinents. À cette étape, l’IA représente un atout considérable : elle permet de gagner un temps précieux dans la recherche et la collecte d’informations.

Grâce aux algorithmes de machine learning, les outils d’IA scannent et agrègent des données issues de multiples sources — réseaux professionnels comme LinkedIn, sites d’emploi tels qu’Indeed ou encore CVthèques spécialisées.

Ces systèmes automatisés construisent ainsi une base de données de candidats riche et actualisée qui offre aux recruteurs une vision globale et pertinente du marché des talents.

La préqualification des candidatures

La préqualification est une étape essentielle du processus de recrutement. Elle consiste à vérifier la cohérence du profil du candidat avec les besoins du poste, souvent à travers un premier échange. Traditionnellement effectuée par un recruteur, cette tâche peut désormais être confiée à des agents conversationnels (chatbots) alimentés par des technologies de traitement automatique du langage naturel (Natural Language Processing – NLP).

Ces chatbots sont capables de dialoguer avec les candidats, de poser des questions ciblées et d’analyser leurs réponses en temps réel. On distingue trois types de chatbots utilisés dans le recrutement :

- Les chatbots informationnels : conçus pour répondre aux questions fréquentes des candidats (modalités du poste, processus de candidature, délais, etc.)

- Les chatbots de matching : capables d’évaluer la compatibilité entre un profil et une offre d’emploi.

- Les chatbots décisionnels : dotés de capacités d’apprentissage automatique, ils évaluent le potentiel du candidat et déterminent s’il doit être orienté vers un recruteur humain.

Ces outils permettent non seulement d’améliorer l’expérience candidat, mais aussi d’accélérer le processus de sélection en filtrant efficacement les candidatures. L’IA soutient également la présélection des candidatures à travers plusieurs techniques complémentaires :

- Le scoring : cette méthode attribue une note à chaque CV selon des critères prédéfinis (mots-clés, expériences, formations, etc.) afin de hiérarchiser les candidatures.

- Le matching : elle compare les compétences et les valeurs du candidat aux besoins et à la culture de l’entreprise pour identifier les profils les plus compatibles.

- Le parsing : cette approche consiste à analyser automatiquement le contenu des CV grâce à l’extraction sémantique afin de structurer les informations clés et les intégrer dans une base de données.

Ces outils permettent d’automatiser la première sélection de manière rapide et objective, tout en laissant au recruteur le soin d’apporter une analyse humaine et qualitative dans les étapes suivantes du processus.

Organisation et déroulement des entretiens

L’intelligence artificielle intervient également dans la phase d’entretien. Certaines entreprises utilisent désormais des outils permettant de réaliser des entretiens en différé. Le candidat répond à des questions préenregistrées par le recruteur avec une vidéo.

Ces enregistrements sont ensuite analysés par une IA à l’aide d’algorithmes d’évaluation prédéfinis. Le système attribue un score d’employabilité en se basant sur des critères multiples, notamment :

- les expressions verbales (choix des mots, ton, fluidité du discours) ;

- les expressions non verbales (gestuelle, posture, micro-expressions faciales) ;

- et parfois même des indicateurs psychologiques et comportementaux

Cette analyse biométrique hybride combine ainsi des données linguistiques et comportementales afin d’obtenir une évaluation plus globale du candidat. À titre d’exemple, certains outils américains d’entretiens automatisés sont capables d’analyser plus de 500 000 points de données à partir de seulement six questions, en observant les réactions faciales et le langage corporel du candidat.

Si ces technologies représentent un gain de temps considérable et une aide précieuse pour la présélection, elles soulèvent également des questions éthiques importantes concernant la fiabilité, la transparence et la protection des données des candidats.

Evaluation finale des candidats

Une fois les étapes de présélection et d’entretien réalisées, l’intelligence artificielle peut continuer à jouer un rôle déterminant dans la phase d’évaluation finale. Elle agit ici comme un outil d’aide à la décision pour les recruteurs, en leur permettant d’affiner leur choix parmi les derniers candidats retenus.

Certaines entreprises utilisent désormais des systèmes d’IA décisionnels capables de classer les profils en fonction des données recueillies tout au long du processus de recrutement. Ces données incluent les résultats de scoring, les analyses du matching ou encore les éléments observés lors des entretiens automatisés.

À l’issue de ce traitement, les recruteurs accèdent à une synthèse complète regroupant :

- les compétences clés du candidat ;

- son niveau de compatibilité avec les besoins et la culture de l’entreprise ;

- ainsi qu’une évaluation globale de son potentiel.

L’objectif n’est pas de remplacer le jugement humain, mais bien de fournir une base d’analyse objective et structurée pour faciliter la prise de décision finale.

Cependant, cette étape soulève une question essentielle : dans quelle mesure l’IA est-elle réellement fiable pour évaluer un candidat ? Les recruteurs doivent rester attentifs aux biais algorithmiques, à la transparence des critères d’évaluation et à la protection des données personnelles afin de garantir un processus de recrutement à la fois performant et éthique.

Quels sont les points de vigilance concernant l’utilisation de l’IA dans les étapes du recrutement ?

Les outils présentés précédemment illustrent la manière dont l’intelligence artificielle peut automatiser plusieurs phases du processus de pré-embauche.

Toutefois, si ces innovations permettent de gagner du temps et d’améliorer l’efficacité, leur utilisation doit se faire avec prudence. L’automatisation du recrutement n’est pas exempte de risques éthiques et humains qu’il convient d’anticiper et d’encadrer.

Les biais algorithmiques

La vitesse de traitement et la capacité d’analyse des intelligences artificielles reposent sur des algorithmes d’apprentissage automatique. Cependant, ces algorithmes sont entièrement dépendants des données sur lesquelles ils ont été entraînés, c’est précisément à ce niveau que peut naître le risque de biais.

Lorsqu’un système d’IA est alimenté par des données incomplètes, peu diversifiées ou déséquilibrées, il peut développer des biais d’entraînement. Ces biais se traduisent par des résultats faussés, reproduisant, voire amplifiant les inégalités présentes dans les données initiales. Il est donc essentiel de former les modèles à partir de jeux de données variés, représentatifs et de qualité afin de garantir des décisions plus justes et objectives.

Par ailleurs, l’accumulation d’outils d’IA tout au long du processus de recrutement renforce ce risque. Un biais non détecté lors du sourcing peut se répercuter et s’amplifier lors du parsing, du matching, puis de l’évaluation finale, créant un effet de cascade difficile à corriger.

Enfin, les technologies de machine learning et de deep learning rendent l’analyse des algorithmes de plus en plus complexe.

À mesure que la logique décisionnelle des systèmes d’IA devient plus sophistiquée — parfois comparée à celle d’un cerveau humain — il devient plus difficile pour les recruteurs de comprendre, tracer et contrôler les critères qui ont conduit à une décision. Cette opacité algorithmique accentue donc le risque de biais et rend indispensable la mise en place de mécanismes de supervision humaine à chaque étape du recrutement.

L’expérience candidat et la marque employeur

L’intégration de l’intelligence artificielle dans le recrutement ne modifie pas seulement les pratiques des recruteurs : elle impacte également l’expérience vécue par les candidats et, par extension, l’image de la marque employeur.

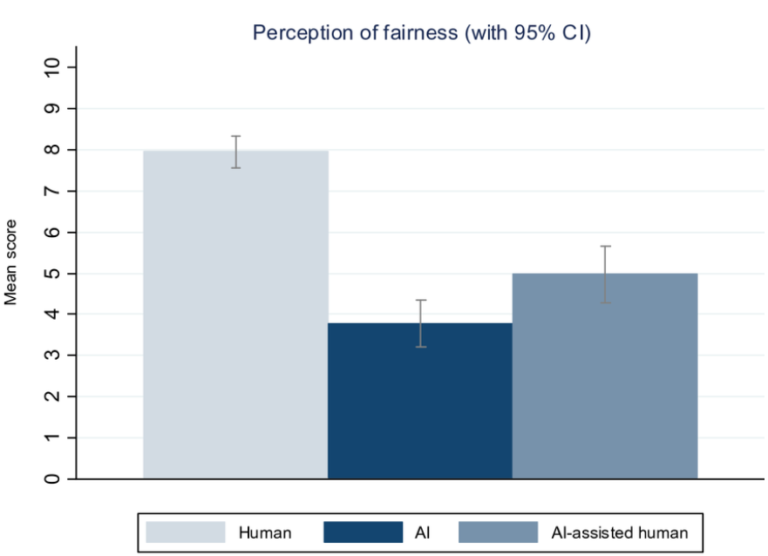

Une étude publiée dans le Journal of Business Ethics a analysé la perception de justice des candidats confrontés à des processus de recrutement automatisés.

Les résultats montrent que :

- les processus entièrement automatisés sont jugés acceptables par moins de 40 % des candidats ;

- cette acceptabilité monte à 50 % lorsque l’humain assiste l’IA ;

- elle atteint près de 80 % lorsque le processus est entièrement géré par un recruteur humain.

Ces chiffres mettent en lumière un point crucial : la présence humaine reste essentielle pour garantir un sentiment d’équité, de reconnaissance et de considération.

Etude sur la perception de la justice chez les candidats du Journal of Business Ethics.

Par conséquent, une automatisation excessive peut donner l’impression d’un recrutement déshumanisé, réduisant ainsi l’attractivité de l’entreprise auprès des talents.

La juridiction

D’un point de vue juridique, l’utilisation de l’IA dans le recrutement constitue un point de vigilance majeur. Si l’automatisation permet d’optimiser certaines étapes du processus, il demeure essentiel de maintenir une intervention humaine afin de garantir la légalité, la transparence et l’objectivité des décisions prises.

En effet, l’article 22 du RGPD consacre le droit pour toute personne de ne pas faire l’objet d’une décision fondée exclusivement sur un traitement automatisé, y compris lorsqu’elle produit des effets juridiques à son encontre. Autrement dit, toute décision de recrutement ne peut être prise uniquement par une IA, sans validation humaine finale.

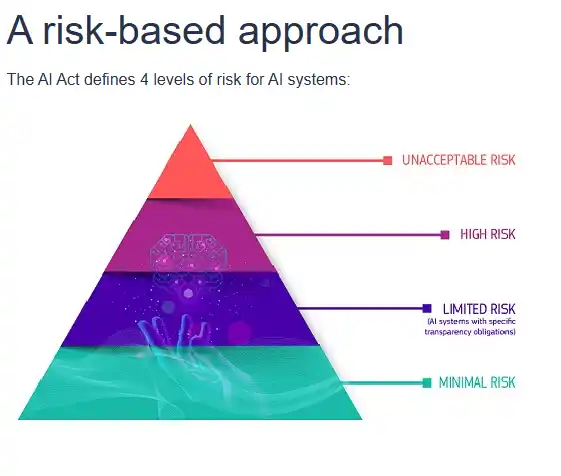

Par ailleurs, le Règlement européen sur l’intelligence artificielle (AI Act), adopté à l’échelle de l’Union européenne, établit un cadre juridique spécifique encadrant l’usage de l’IA selon différents niveaux de risque. Le secteur du recrutement y est classé parmi les activités à haut risque, en raison de son impact direct sur les droits fondamentaux des individus (emploi, égalité de traitement, non-discrimination).

Ainsi, les entreprises qui recourent à l’IA dans leurs processus de recrutement se voient dans l’obligation de :

- veiller à la conformité de leurs outils avec le RGPD et l’AI Act ;

- garantir la transparence des critères de décision utilisés par les systèmes automatisés ;

- s’assurer d’une supervision humaine à chaque étape clé du processus.

Ces précautions visent à encadrer l’usage de l’IA pour qu’elle reste un outil d’assistance, et non un substitut au jugement humain, dans une logique de respect des droits et libertés des candidats.

Comment l’IA ACT encadre l’utilisation de l’intelligence artificielle ?

Depuis le 1er août 2024, l’IA Act est entré progressivement en vigueur dans l’Union européenne. Ce règlement établit un cadre de conformité destiné à encadrer l’usage de l’intelligence artificielle selon le niveau de risque qu’elle présente pour les droits fondamentaux, la sécurité ou la vie privée des individus.

Selon la Commission européenne, quatre niveaux de risque sont définis :

- Risque inacceptable – systèmes d’IA interdits, jugés dangereux pour les droits ou la sécurité (ex. notation sociale).

- Risque élevé (haut risque) – systèmes autorisés sous conditions strictes de transparence, de contrôle et de supervision humaine.

- Risque limité – systèmes nécessitant des obligations d’information, notamment vis-à-vis des utilisateurs.

- Risque minimal ou nul – systèmes considérés comme sans danger particulier, ne faisant l’objet d’aucune contrainte réglementaire spécifique.

Le secteur du recrutement est expressément classé comme à haut risque, compte tenu de l’impact direct que les décisions automatisées peuvent avoir sur la carrière, la réputation ou l’avenir professionnel des individus. Les activités telles que la sélection de candidatures, le tri de CV, la conduite d’entretiens automatisés ou encore les décisions de promotion et de gestion du personnel relèvent de cette catégorie.

À partir du 2 août 2026, plusieurs types de systèmes d’IA utilisés dans le recrutement feront l’objet de restrictions et d’obligations renforcées, notamment :

- les systèmes d’IA destinés au recrutement ou à la sélection de personnes physiques, y compris la publication d’offres ciblées, l’analyse et le filtrage des candidatures, ou l’évaluation des candidats ;

- les systèmes d’IA utilisés pour prendre des décisions relatives aux conditions de travail, à la promotion, à la résiliation de contrat, ou pour attribuer des tâches en fonction du comportement ou des caractéristiques personnelles ;

- les systèmes servant à surveiller ou évaluer les performances et le comportement des travailleurs dans le cadre de leur activité professionnelle.

En d’autres termes, toutes les entreprises qui utilisent l’IA pour des tâches telles que le parsing, le scoring, le matching, ou la préqualification de candidatures sont désormais considérées comme utilisatrices d’IA à haut risque.

Les acteurs du recrutement doivent dès à présent anticiper ces évolutions réglementaires et intégrer des mesures de gestion et de compensation des risques.

Cela implique notamment :

- une évaluation de conformité des outils utilisés ;

- la mise en place de procédures de transparence envers les candidats (explication du rôle de l’IA dans les décisions) ;

- et la supervision systématique par un être humain des décisions automatisées.

L’objectif de l’IA Act n’est pas de freiner l’innovation, mais de garantir une utilisation responsable, transparente et éthique de l’intelligence artificielle dans les pratiques de recrutement.

Comment se conformer à cette législation et quelles sont ses sanctions ?

A noter : les mesures de compensation des risques

- Des dispositifs d’évaluation et d’atténuation de ces risques

- Une meilleure qualité de données dans l’algorithme de l’IA

- Une journalisation de l’activité pour assurer la traçabilité des résultats

- Une documentation détaillée fournissant toutes les informations nécessaires sur le système et son objectif pour permettre aux autorités d’évaluer sa conformité

- Des informations claires et adéquates à l’intention du déployeur

- Des mesures de surveillance humaine appropriées

- Un niveau élevé de robustesse, de cybersécurité et de précision

Pour se conformer aux exigences de l’IA Act, les organisations utilisant des systèmes d’intelligence artificielle à haut risque, notamment dans le domaine du recrutement, doivent mettre en place un ensemble de mesures techniques et organisationnelles visant à garantir la sécurité, la transparence et la conformité juridique de leurs outils.

Le non-respect de ces obligations peut entraîner des sanctions particulièrement sévères.

Les pratiques non conformes liées à l’utilisation d’IA à haut risque sont passibles d’amendes pouvant atteindre :

- jusqu’à 15 millions d’euros ;

- jusqu’à 3 % du chiffre d’affaires annuel mondial de l’entreprise, selon le montant le plus élevé.

Ces sanctions seront applicables à compter du 2 août 2027, date d’entrée en vigueur complète des dispositions relatives aux systèmes à haut risque.

L’automatisation du recrutement par l’intelligence artificielle reste un outil à double tranchant. Si elle permet un gain d’efficacité et une meilleure gestion des candidatures, elle impose, en contrepartie, une grande rigueur éthique et juridique.

Les organisations doivent veiller à ne pas se reposer entièrement sur l’IA, au risque d’exclure des talents ou de porter atteinte à l’équité du processus. Il est donc indispensable de préserver une intervention humaine à chaque phase du recrutement, afin de concilier performance technologique, conformité réglementaire et respect des candidats.